2025-11-28

膨大なデータから

膨大なデータから

導き出した最適解で

世界を変える

ARISE analyticsとは

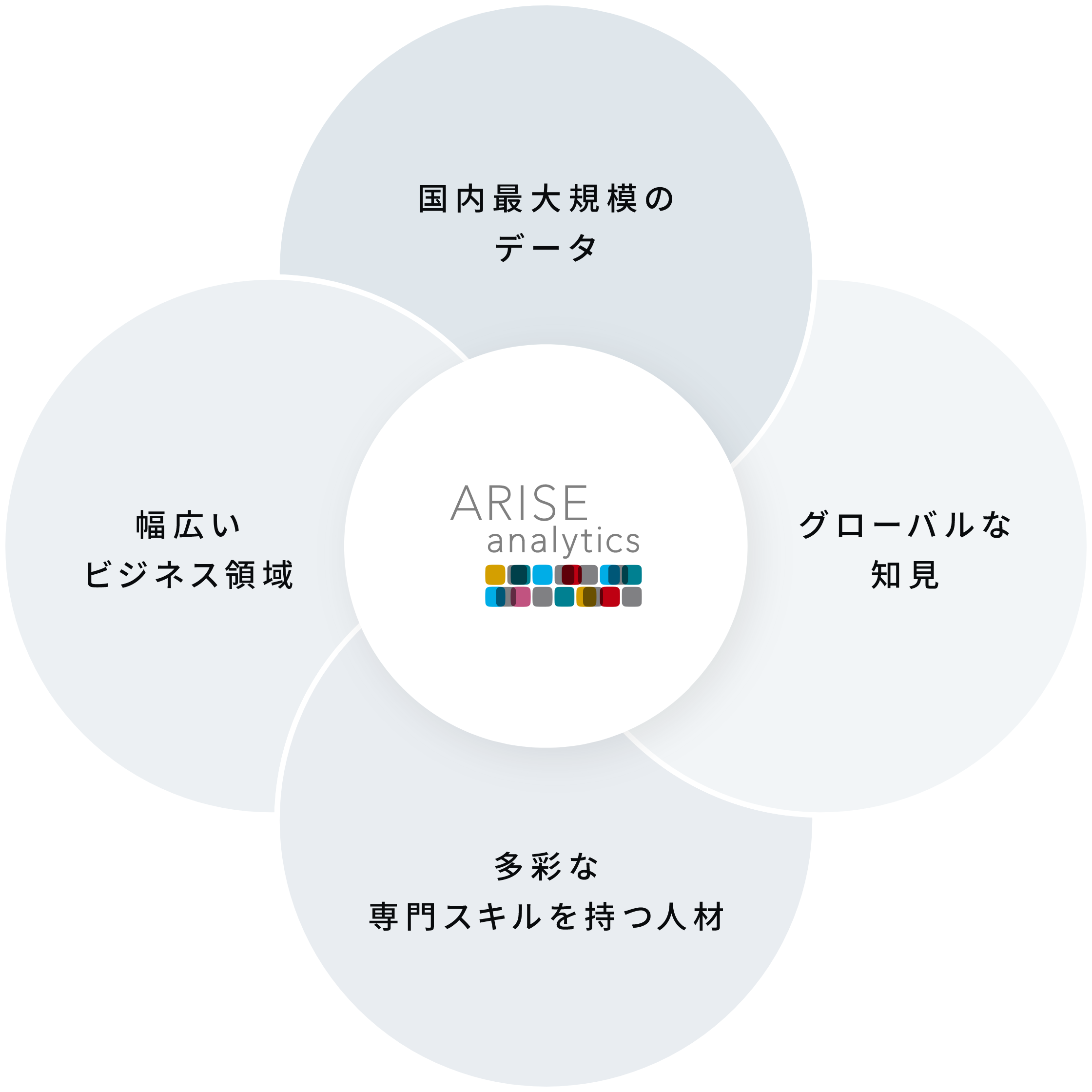

ARISE analyticsは、KDDIが保有する国内最大規模のユーザーデータと、アクセンチュアの持つアルゴリズム構築力を背景に、2017年に誕生しました。

データそれ自体はただの情報ですが、データサイエンティストの手によって、未来を切り拓くための原動力に変えることができます。

私たちが目指すのは、データを起点にビジネスを再構築し、アナリティクスによってビジネスを、そして社会を変えることなのです。

サービス/実績

私たちは、データアナリティクスとAIで

新たな価値創造を支援します。

事例

-

大阪府河内長野市がKDDIと「スマートソリューションパートナーシップ協定 」を締結。デジタル技術を活用した社会課題の解決、地域共創を推進。

大阪府河内長野市がKDDIと「スマートソリューションパートナーシップ協定 」を締結。デジタル技術を活用した社会課題の解決、地域共創を推進。 -

因果推論・時系列などの分析モデルを活用して、通信事業とライフデザイン事業の融合を目指すKDDIの高度分析プロジェクト

因果推論・時系列などの分析モデルを活用して、通信事業とライフデザイン事業の融合を目指すKDDIの高度分析プロジェクト2025-10-30

-

KDDIが「auサポート AIアドバイザー」で提供する、デジタルヒューマンを活用した次世代のカスタマーサポート体験

KDDIが「auサポート AIアドバイザー」で提供する、デジタルヒューマンを活用した次世代のカスタマーサポート体験2025-10-30

-

KDDIが取り組むデータを活用した通信ネットワーク改革と、AIドリブンな次世代ネットワークの構築

KDDIが取り組むデータを活用した通信ネットワーク改革と、AIドリブンな次世代ネットワークの構築2025-06-20

-

ダッシュボードを活用して代理店支援を強化 データドリブンな施策で収益を拡大するKDDIの営業DX

ダッシュボードを活用して代理店支援を強化 データドリブンな施策で収益を拡大するKDDIの営業DX2025-05-21

-

KDDIのデータドリブンマーケティングを牽引する「R&Aセンター」 データ分析の文化の浸透、意識改革にも大きな貢献

KDDIのデータドリブンマーケティングを牽引する「R&Aセンター」 データ分析の文化の浸透、意識改革にも大きな貢献2025-05-20

WE ARE HIRING

採用情報

チャレンジし続けられる

フィールドが、ここに

ARISE analyticsは、KDDIが保有する膨大なデータ基盤を活用し、データサイエンスとAIの力でお客さまや社会の課題解決に貢献しています。

今後の当社の担い手となるあなたのために。

成長意欲を満たす教育プログラムや独自メソッドを採用し、全力でサポートする体制と環境を整えています。

今、ともに磨きあえる仲間との出会いに期待を膨らませています。

ニュース

-

2025-12-12

公式noteにて『渋谷ラスト開催!納会「アラフェス2025」をレポート!』という記事を更新しました

-

2025-12-12

「ARISE TECH BLOG」にて、 「アンケートの限界を超えろ ―― サーベイ実験のすすめ(その①) 動機編」という記事を更新しました

-

2025-12-12

ARISE analyticsの取組が、内閣府男女共同参画局の広報誌「共同参画」12月号に掲載されました

ARISE analyticsに関するご質問・

お問い合わせは

こちらよりお送りください

お問い合わせは

こちらよりお送りください